В тази статия, примери за добри, по мое мнение, кодът за файла robots.txt за WordPress, който можете да използвате в своите уебсайтове.

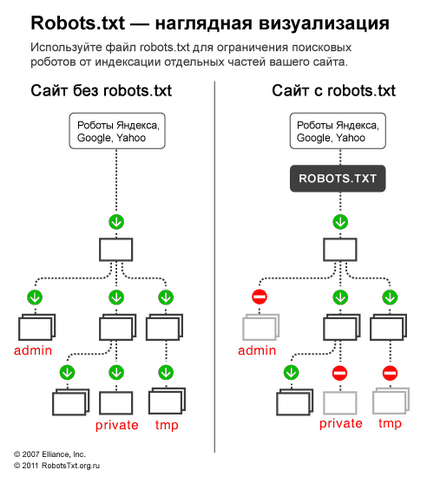

Като начало, не забравяйте, защо имате нужда от robots.txt - файла robots.txt, е необходимо само за търсачките, за да "каже" какво ги раздели / и, които не е необходимо да посетите страницата, за да посетите сайта. Страници, които са затворени за посещения, няма да попадат в индекса на търсачките (Yandex, Google и т.н.).

Вариант 1: оптимален robots.txt код за WordPress

В съответствие User-Agent: * уточняваме, че всички от следните правила ще работи за всички роботи за търсене *. Ако искате право да работят само за един конкретен робот, вместо * Показва името на робот (User-агент: Yandex User-Agent :. Googlebot).

- Disallow: / CGI-бен - затваря директорията на скриптове на сървъра

- Disallow: / емисия - затваря RSS емисия на блога

- Disallow: / собствен сайт - затваряне на предизвестие

- Забрани. ? S = или Disallow: * S = - страница за търсене zakryavet

- Забрани: * / страница / - обхваща всички видове страниране

От документацията Yandex: «домакин - независим директива и работи навсякъде във файла (Разделяне)". Ето защо, да го настроите в горната или в самия край на файла, чрез празен низ.

Това е важно: правилата за сортиране преди началото на лечението

Yandex и Google обработва директиви позволява и Забрани никакъв определен ред, по който те се появяват и първите им сортира от кратък и дългосрочен правило, а след това процесите на миналата съвпадение правило:

За да се разберат бързо и да използвате функцията за сортиране, не забравяйте следното правило: "по-дългосрочен правилото в robots.txt, за по-голям приоритет има. Ако правилата на една и съща дължина, приоритетът е дадено да се даде възможност директива. "

Вариант 2: Standard robots.txt за WordPress

Аз не знам как някой, а аз за първи вариант! Тъй като това е по-логично - няма нужда да се дублират напълно раздела с цел уточняване на директивата за домакин на Yandex, който е междусекторна (разбира като робот навсякъде в шаблона, без да се уточнява, към която принадлежи към робота). По отношение на нестандартно Позволете директива. тя работи за Yandex и Google, и ако тя не се отвори папката, качено за други роботи, които не разбират, а след това 99% няма опасност от не води. Аз не съм забелязал, че първите роботи не работи както трябва.

Някои роботи (не Yandex и Google) - не разбират директивите повече от 2: User-Agent: и Забрани :;

3. Карта на сайта: Разделяне насока за Yandex и Google, и най-вероятно за много други роботи, също така, че е пиша в до края на празен низ, и тя ще работи за всички роботи наведнъж.

Въз основа на тези изменения, правилния код трябва да изглежда така:

Добавя за себе си

Ако искате да затворите всички записи / новини. пишем:

По-подробна проверка на robots.txt за директива можете да помогнете страница на Yandex (но имайте предвид, че не всички правила, които са описани там, да работи за себе си).

Crawl-закъснение - време, за луди роботи

Когато Yandex пълзи сайтове като луд, а това създава излишна тежест на сървъра. Роботът може да бъде помолен да "помете скоростта на вълната".

За да направите това, използвайте директива Crawl-закъснението. Това показва времето в секунди, че роботът да е неактивно (изчакване), за да сканирате всяка следваща страница.

За съвместимост с роботи, които не са добре, последвани robots.txt стандарт, Crawl-забавяне е необходимо да определите група (в раздел User-Agent) и веднага след Disallow Позволете

Робот Yandex разбира частични стойности, например, 0.5 (половин секунда). Това не гарантира, че той ще ги посещават вашия сайт всеки половин секунда, но за да се ускори байпас сайт.

Google робот не разбира директива Crawl-закъснението. Timeout роботи му могат да ползват уебмастър панел.

Проверка robots.txt и документация

Свързани статии