Преди да започнем да говорим за два екземпляра, Александър даде определението на дубликат страница на сайта:

Двойки - две или повече страници от същия сайт. които съдържат идентичен или подобен достатъчно текстово съдържание.

Причини за възникване на двойки на сайта - и много от тях са свързани с различни грешки. Например:

Грешки в страници със съдържание:

• неправилни относителни връзки

• Без текст

• HTTP-200 вместо HTTP-404

• наличие на специални страници

Голяма част от възможните причини за дубликати обикновено е много потиснати от уебмастъри и те определят тяхното търсене за неопределено време, не искат да си губи времето с него. За да направите това, не си струва, защото наличието на дублиращи се страници на сайта често води до различни проблеми.

01 | Опасност отнема онлайн

Проблемите, които са резултат от двойки:

• Промяна на съответните страници в резултатите от търсенето

• Байпас дублирани страници

• Трудността на събиране на статистически данни

Промяна на съответната страница

Роботът не съхранява в своите бази данни няколко еднакви документи, така че търсенето е само един от тях - по преценка на робота. Изглежда, че няма нищо лошо в това, тъй като идентична страница. Въпреки това, опитни уебмастъри знаят, че позицията на определена страница от нуждите се изчислява на базата на няколко стотин показатели, така че ако промените страницата с резултати от търсенето, позицията може да се промени.

След известно време, подходящи страници върнати на проблема, но е очевидно, че дори малка промяна може да повлияе на размера на трафика на ресурса.

Байпас на дублиращи се страници

При наличието на голям брой дубликати в ресурса, търсещият робот за постоянно посещение на голям брой страници. Тъй като броят на заявките от индексиране робот е ограничено (производител на сървъра или CMS сайт уебмастър с помощта на директивата за Crawl-закъснение), тя е в присъствието на голям брой дублирани страници, той започва да ги изтеглите, вместо желаната индекс. В резултат на това, резултатите от търсенето могат да бъдат показани всички неподходящи данни, а потребителите не могат да намерят необходимата им информация, въпреки че тя е на разположение на интернет страницата.

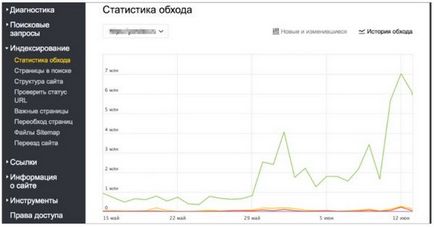

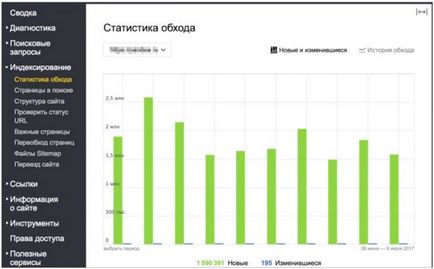

Практически пример за заобикаляне на дублиращи се страници, от които става ясно, че в края на май робот изтеглен ежедневно малко по-малко от един милион страници на електронен магазин. След актуализиране на ресурса и да направите промени в сайта, роботът започва да драстично да увеличи натоварването на ресурсите Свалянето на няколко милиона страници на ден:

Повечето от тези страници - двойни, с неправилни Get-параметри, които се появяват в резултат на неправилна експлоатация на CMS, които се използват на сайта.

Проблеми с събиране на статистически данни в Yandex.Webmaster и Yandeks.Metrike

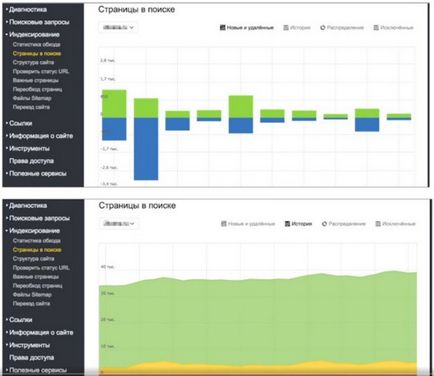

Ако говорим за уебмастъри, раздел "страници, за да открият" могат да се видят тук е снимка:

Всеки път, когато се актуализира базата данни за търсене, броя на страниците в търсенето на практика остава непроменен, но е ясно, че на робота при всяка актуализация добавя и премахва за същия брой страници. Това означава, че някакъв процес се случва, винаги има какво да се отстрани и се добавя, като броят на страниците в търсене на останки непроменени. Ако видите статистиката от посещенията, можем да видим, че роботът се посещава от хиляди нови страници на сайта, с тези нови страници в резултатите от търсенето не попадат. Това е точно същото и е свързан с дублиращи се страници робот за обхождане, които след това в резултатите от търсенето не са включени.

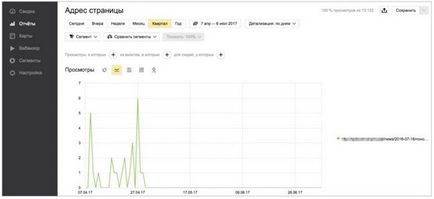

Ако видите статистиката за посещаемостта на определена страница в Яндекс. Metric, може да възникне следната ситуация: Тази страница показва по-рано при специално искане и на него бяха референции от резултатите от търсенето, които по някаква причина са спрели в началото на май:

И по-долу се случи - се присъедини в резултатите от търсене на дублиращи се страници, а потребителите с търсене започна да се движи по нея, а не от дясната страница.

Тя ще изглежда, че тези три големи проблеми, причинени от наличието на дублиращи се страници на сайта, трябва да бъдат мотивирани уебмастъри, за да ги премахнете. И за да се отстранят дубликати от сайт, първо трябва да ги намерите.

02 | Търсене дубликат

- Виждате ли страницата дубликат?

- No.

- И аз не съм. И са те.

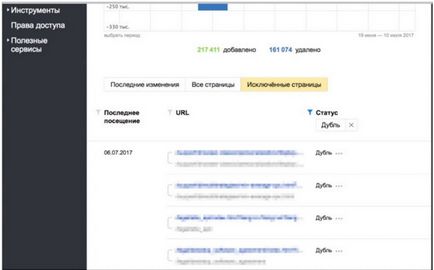

Най-лесният начин за търсене на дублиращи се страници - това е с помощта на раздела "страници, за да се намери" в Yandex.Webmaster:

Страници в търсене -> Изключени страница -> Сортиране по: Резерви -> Приложи

В резултат на това, можете да видите всички страници, които изключват робот, да ги обмисля дубликати.

Ако има много страници, например, няколко десетки хиляди, могат да бъдат получени от качването уебмастъри страница продължат да я използват по свое усмотрение.

Вторият метод - използва секцията "Статистика" байпас:

Байпас Статистика -> Сортиране по: 200 (OK)

В този раздел можете да видите не само страниците, които се посещават от робота, а не само на двойки, но и различните страници на услуги на сайта си, че търсят да видят не искат да.

Третият начин - с помощта на фантазията.

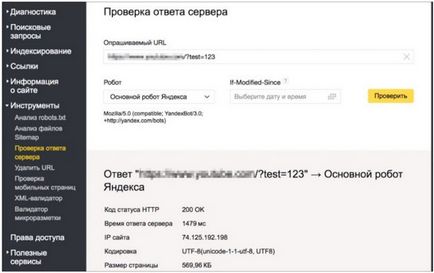

Вземете който и да е страница на сайта, както и да добавите към него произволно GET-параметър (в този случай / тест = 123 С инструмента "Проверка отговор на сървъра", провери кода на отговора на тази страница?.:

Ако страницата е налична и реагира, както и в кода на снимки, отговор 200, тя може да доведе до появата на дублиращи се страници на сайта. Например, ако един робот намира някъде връзка в интернет, той ще бъде индексирано от него и потенциално може да стане излишно.

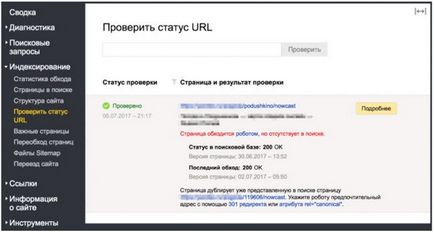

Четвъртият начин - е да проверите състоянието на URL.

В ситуация, в която желаната страница е изчезнал от резултатите от търсенето, с помощта на този инструмент, можете да проверите на какво точно причинява това се е случило:

В този случай, ясно е, че страницата е била отстранена от търсенето, тъй като е в двоен размер.

В допълнение към тези четири метода може да се използва дори и някои от пътищата му, например: виж трупи от вашия сървър, статистика Yandeks.Metriki, в крайна сметка, за да видите резултатите от търсенето, също така е възможно да се идентифицират дублиращи се страници.

03 | дедупликация

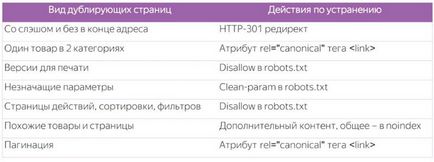

• Очевидни дубликати (напълно идентично съдържание)

• Косвени двойни (страници с едно и също съдържание)

- HTTP-301 пренасочва от една страница към друга с помощта на .hitacces / CMS

Кои страници трябва да се оставят да реши за себе си уебмастър робот във всеки отделен случай. Посетете страниците на вашия сайт, за да разберете кои от тях се намират в нея в момента, и да вземе решение въз основа на тези данни.

- използвайте отн = "каноничен" маркер атрибут

3. версия за печат

4. Страници с незначителни параметри

site.ru/page

site.ru/page?utm_sourse=adv

site.ru/page?sid=e0t421e63

Привлича помощта на специална директива Clean-Парам в robots.txt и посочете всички незначителни параметри, които се използват на сайта -

5. Страниците на действие на сайта

site.ru/page?add_basket=yes

site.ru/page?add_compare=list

site.ru/page?comment_page_1

Забраната в robots.txt -

site.ru/игрушки/мяч

site.ru/игрушки/ играчка / играчки / играчки / топка

1. Търсите източник на

2. HTTP-404 се приспособява към тези искания

7. Подобни артикули

- Ние си запазваме стоките на един URL и използвайте инструмента за избор (способността да изберете желания цвят и размер)

- Добавяне на страниците на допълнително описание на такива прегледи

- Затворете необходимо да Noindex

8 страници със снимки без описание

Page фото галерии, фото банки

9. филтрирате и сортирате Pages

- Определете значение и полезност резерв

- За да се постави тази безполезна забрана в robots.txt -

10. Pages страниране

site.ru/shop/catalog/podarki/

site.ru/shop/catalog/podarki/?page_1

site.ru/shop/catalog/podarki/?page_2

Ние използваме отн = "каноничен" маркер атрибут

04 | изводи:

Причини и видове дубликати различни, толкова различни и трябва да се подходи към тях от гледна точка на оптимизация за търсещи машини на. Те не трябва да се подценява. Често трябва да погледнем в Webmaster и бързо да направите необходимите промени в сайта.

Яслите да работи с отнема:

Свързани статии