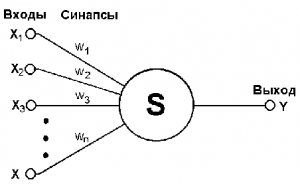

неврон модел от [1]

Входът се подава импулс вектор Xn на, състояща се от п числени атрибути. Вътре в неврона импулси са оформени с определени тежести WJ. и J = 1..N, ако общата инерция на S (х) = ^ п "/> aktivatsiiw0 надвишава прага след неврона се възбужда и произвежда стойност на (х) = S (х) -. w0.

Ако добавим сляпо импулсен вход x0 ≡ -1 и сравни го W0 тегло - праг активиране може да пише по-компактно след това излезте от формулата Y (х):

а (х) = (W, X). където (W, X) - скаларен продукт, w и х - векторите на тежести и пулс знаци, съответно.

Образование адалин

Като се има предвид набор обучение: набор от входни стойности X и Y. много нововъзникващи стойности, така че всеки вход съответства на YJ XJ - вън, J = 1..m. Необходимо е тези данни, за да се изгради адалин, което дава възможност за най-малко количество грешки в това обучение комплект. Адалин Образованието е да изберете "най-добрите" стойностите на векторни на тежести W. Какво определя стойността на остатъка е по-добре функционална загуба .В адалин използва функционален предложен Vidrou и Hoff, L (А, X) = (А - у) 2. Така функционалните да бъде сведена до минимум Q (w).

Ние прилагаме метода на градиент произход. тогава следната стойност ще бъде във вида :, където - скоростта на обучение.

Шофиране обучение адалин

- - обучение проба от м елементи

- - учене темпо

- - функционален параметър изглаждане

- Initialize тегло;

- Инициализиране функционален първоначална оценка;

- повтарям:

- Изберете обект от (например, на случаен принцип);

- Изчислете грешка;

- Степенен градиент спускане :;

- Оценка на функционалното значение :;

- До стойност се стабилизира и / или тегло не спира да се променя.

Комуникация обучение адалин с стохастична Gradient

Схема живот съответства адалин линеен класификатор метод живот на стохастичен градиент в линеен активиране функция Ф е (Z) = Z и квадратичен загуба функция L (А, X) = (А - у) 2.

Свързани статии