Към днешна дата, търсачките - това е един от най-простите и най-ефективните начини за бързо да намерят отговор на въпроса ви, да получите последните новини или да закупите стоки, които са много трудно да се намери в магазините. Но нека да погледнем в очите на собствениците на търсачката на уеб-ресурси. Има доста високо качество и полезни сайтове, до които потребителят просто идва от факта, че те са близки и не попадат в топ 10 или дори водещите резултати от 50 за търсене.

Понякога напълно оптимизирани ресурси с отлични оценки и доверени търсачките се класират по-скоро лошо. Една от основните причини за това е големият брой на дубликати и "безполезни" (от гледна точка на търсачките) страници в индекса.

Основното и най-ефективен инструмент за борба с двойки винаги е robots.txt стандарт. Нейната основна цел - отстраняване на нежелани страници индекса, което е много важно за ефективно и ефикасно насърчаване на вашия сайт в търсачките. Ние няма да се спирам подробно на теоретичното описание на целите и синтаксиса на този файл. Това може да се чете на английски и руски тематични ресурси. Ние считаме, че в подробности практическата страна на този стандарт, когато се движат в търсачката Google.

- Без индексиране на отделните страници, файлове и директории.

- Възможност за регулиране на резолюцията относно индексирането на отделни файлове в директория, която е затворена от индексация ( «Разреши» директиви да укажете при съответните директиви «Disallow»).

- Лесен за употреба, в сравнение, например, мета-таг (Това трябва да бъде посочен на всяка страница, която искате да затворите индексация, докато файла robots.txt ви позволява да закрие цели директории).

- Възможността за затваряне на целия сайт да бъде индексиран от уточняване "Забрани директиви: /" (затваряне на тестовата версия преди "ставам" новия уебсайт).

Въвеждане в вторичен индекс

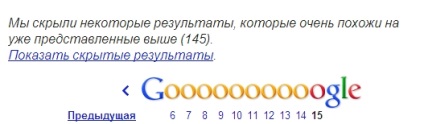

Страници, които затварят индексация е вероятно да получите още в индекса на Google. По-специално, тези страници могат да бъдат намерени в под индекса на търсачката, която отправя искане чрез «сайт: моето място .com» операторът ". Покажи скритите резултати" и кликнете върху

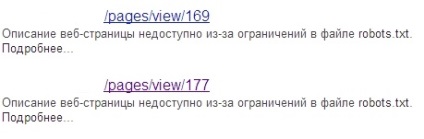

Тези страници са в индекса ще има съответното описание, под линка към тях:

Както е известно, наличието на голям брой страници на вторичния индекс - това е бавен индексиране на сайта от Google, както и намаляване на позиции в резултатите от търсенето се дължи на факта, че на мястото, в съответствие с търсачката, има много "безполезен" на страниците на потребителите и т.н. . п.

Неправилно четене на файл търсачката

Друг съществен недостатък е, че Google не може правилно да прочетете информацията в файла robots.txt. Поради това, нормалната страница може също да премине в вторичния индекс.

Например, тук са директивите, които са посочени във файла robots.txt, сайт, A:

Но ситуацията е, че има в индекса на Google, ако заявката помощта на «сайт» оператор:

На първо място. използване на «сайта» операторът винаги проверите наличността на желаните страници в основния индекс. На второ място. Използвайте следните методи, за да забраните индексирането на отделни страници.

- Посочва се в блок мета тагове

] " LT; Мета име = LAQUO; роботи RAQUO; съдържание = LAQUO; Noindex. Nofollow RAQUO; GT;

] " LT; Мета име = LAQUO; роботи RAQUO; съдържание = LAQUO; Noindex. следвам RAQUO; GT;

Недостатък на този метод е, че страницата, на която тя е била регистрирана мета тагове. Не винаги, обхваната от индексация. Има случаи, когато съдържанието на тези страници успешно индексирани в Google. В този случай, "за хеджиране" може да се прибегне до друг метод, който е описан по-долу.

Това работи добре не само за цялата страница на двойки (например версия за печат), но също така и за частични дубликати. Например, има няколко страници за един и същ продукт, представен в различни цветове на сайта. Оптимално, като в същото време ще избере една от тези страници, които са ключово (например, стоките в най-популярната цветова схема), а останалите страници в атрибута той посочва като каноничен.

С този инструмент, можете да премахнете не само определена страница от индекса на Google, но и всички страници в този каталог, специфичната изображение или дори цял сайт. Единственият съвет: Внимателно прочетете указанията на Google за използването му.

- "Лепило" дубликати, използвайки 301-то на сървъра пренасочване

Напоследък нова страница след 301-ва пренасочване спадът на индекса през 1-3 дни след изпращане на заявката. Единствената уговорка: по-добре е да не се закрие старите страници от индексирането, защото тогава Той няма да бъде в състояние да стигнем до тях, както и "лепило" с желаната страница.

- С използване на HTTP-заглавна отн = «канонически»

Прилагането на този метод е оптимална за различни типове файлове с различни разширения. PDF формат. XLS и др.

За да обобщим, ще отбележа, че проблемът за справяне с двойки винаги е била и е от значение за всички SEO-експерти. Така че не се страхувайте да експериментирате, използвайте различните варианти за справяне с двойки, за да направи оценка на резултатите и прави заключения въз основа на практика, а не на базата на голи теория.

Има ли начин да се масово изтриване на страници от индекса на Google забранено в robots.txt (те са били в допълнителната индекса)? Аз предписано за тях, но те са повече от един месец, все още да останат в индекса. Премахване на едната ръка за прекалено дълго. Дайте им 404-грешка някак идеологически правилни. Все още има начин да се работи?

Най-вероятно, след като сте се регистрирали за тези страници Google робот, за да ги все още не са достигнали, и съответно, той все още не знае, че те са затворени от индексация.

Ако това е тяхната индексирани след като ги затваря с помощта на роботи, но те все още са в основния индекс, това означава, че сте направили нещо нередно.

Ако тези страници не са много, опитайте се да ги премахнете ръчно чрез GWT. Или изберете обекта 301 пренасочи към началната страница с всички срещания на несъществуващи.

301 Начало изпълнен!

ръчно, така че е необходимо да се премахне за постоянно (и ефективно)!

Ако имате метод, който ще ви позволи да се реши по-горе проблем възможно най-ефективно, а след това да ги споделите с всички честни хора :)

Не мисля, че направих нещо не е наред. По-ефективен начин - е да се регистрирате отн = каноничен на тези страници, то Googlebot по-добре и по-отзивчиви, отколкото на мета роботи (най-важното, че след propisaniem Canonical Googlebot видя на страницата).

Владислав, за това, че след затваряне на роботи страници са все още в индекса - така че това е една стара практика. Наистина, оптимизатор не вижда проблема. Има дори и в горната част на страницата, за някои заявки са затворени за роботите! И как смятате, че - е уебмастър нещо не е направено. Или може би, все пак, на Google темперирани.

За съжаление, от отглеждането на редица неясни 404 и страдам :(

Те не се появи ясно къде и индексирани добре, докато не видя един начин - да се провери и коригира ръководство в GWT.

301 у дома след дълго не съществува. Владислав, прочетете статията, може да бъде малко по-ясна за вас ще бъде SEO-промоция: