Osnovopolozhennik теорията на информацията, Клод Шанън дефинирана информация. Как да премахнете тази несигурност. По-точно, за да се получи информация - необходимо условие за премахване на несигурността. Несигурността възниква в ситуация на избор. Проблемът трябва да бъде решен по време на отстраняване на несигурността - намаляване на броя на разглежданите варианти (намаляване разнообразие) и в резултат на избор на един от съответната ситуация измежду възможните варианти. Премахване на несигурността дава възможност да се вземат информирани решения и да действат. В тази информация управление роля.

Представете си, че отидох до магазина и помоли да ви продаде на венците. Продавачката, който, да кажем, 16 разновидности на дъвки в състояние на несигурност. Тя не може да се съобрази с искането без повече информация. Ако сте посочили, да речем, - «Орбита", и 16 от първоначалния опции продавачка на вижда сега само 8 можете намали несигурността два пъти (гледаме напред, да кажем, че намаляването на несигурността съответства на два пъти получи един бит информация). Ако не сте, че още отсега, просто посочи с пръст към прозореца, - "ето това", несигурността е премахнат напълно. Отново, гледаме напред, ние казваме, че този жест в този пример, вие сте казал на продавачката 4 бита информация.

Максимална ситуация на несигурност предполага няколко equiprobable алтернативи (варианти), т.е. нито един от вариантите не е за предпочитане. Нещо повече, толкова повече възможности има еднакво, толкова по-голяма несигурност, толкова по-трудно да се направи ясен избор, и се изисква колкото повече информация, за да се получи това. За версии N, тази ситуация е описано от следното разпределение вероятност :.

Минимална несигурност е 0. т.е. тази ситуация е пълна сигурност. което означава, че изборът е направен, и се получава цялата необходима информация. разпределението на вероятността за ситуация на пълна сигурност, както следва :.

Количество, което характеризира количеството на несигурност в теорията на информацията е обозначен с Н символ и се нарича ентропия, или по-скоро информация ентропията.

Ентропия (Н) - мярка на несигурност, изразено в бита. Просто ентропия може да се разглежда като мярка за уеднаквяване на разпределение на случайната променлива.

Фиг. 8. Поведението на ентропия в случай на двете алтернативи.

Фигура 8 показва поведението на ентропията за случая на две алтернативи, с промяна на съотношението на вероятности (р, (1-п)).

Ентропията достига максималната стойност, в този случай, когато двете вероятностите са равни помежду си и равни ½, нулевата стойност на ентропията съответства на случаите (p0 = 0, p1 = 1) и (p0 = 1, p1 = 0).

Количеството информация I и ентропията Н описва същата ситуация, но с качествено противоположните страни на. I - е количеството информация, която се изисква, за да се премахне несигурността H. Leon Брилуеново По информация определение ентропия е отрицателен (отрицателна ентропия).

Фиг. 9. Връзката между ентропия и количеството на информацията.

Когато несигурността отпада напълно, размерът на получената информация е равна на първоначално съществувах H несигурност.

В случай на частично отстраняване на несигурност, размерът на получената информация, а останалите unwithdrawn несигурност, която е в първоначалната несигурност. Ht + Той = Н.

Поради тази причина, формулите, които ще бъдат дадени по-долу, за да се изчисли ентропията и H са формулите за изчисляване на размера на информация, която е I. когато става въпрос за пълното премахване на несигурността. Н него може да бъде заменен от I.

В най-общия случай. ентропия Н и броя, получен чрез отстраняване на несигурността на информацията, която зависи от първоначалното количество счита варианти N и априори вероятности на всеки изпълнение P: 0. Р1. ... PN-1>. т.е. Н = F (N, P). ентропия изчисление в този случай се базира на формула на Шанън. той предложи през 1948 г. във вестника "Математическа теория на комуникацията".В конкретния случай. когато всички възможности са еднакво вероятни. зависи само от броя на разглеждани варианти, т.е. Н = F (N). В този случай, формулата Шанън е значително опростена и съвпада с формулата Хартли. който за първи път е предложен от американския инженер Ралф Хартли в 1928 г., т.е. не 20 години по-рано.

Shannon формула е както следва:

В знак минус във формулата (1) не означава, че ентропията - отрицателна. Това се обяснява с факта, че пи £ 1 по дефиниция, и логаритъма на броя на по-малки единици - отрицателна. Според логаритъм на имота. Ето защо, тази формула може да се запише във втория вариант, без знак минус пред количеството.

Това се тълкува като броят на лична информация. получено в случай на I-та версия. Shannon ентропията във формулата е вторична характеристика - математическата очакването на случайна променлива разпределение 0. I1, ... IN-1>.

Пример за изчисляване на Shannon ентропията формула. Нека в някаква част от създаването на служители, разпределени както следва: ¾ - жена, ¼ - мъже. Тогава несигурността, например, за това дали да се запознаем на първата, ще институцията ще се изчислява до които е показано в Таблица 1.

Shannon формула (1) съвпада по форма с формула Болцман, получен от преди 70 години за измерване термодинамична ентропията на идеалния газ. Тази връзка между количеството на информация и термодинамична ентропия служи като първа причина за разгорещени дебати, а след това - ключът към решаването на редица научни проблеми. В най-общия случай, ентропията се разбира като мярка на разстройство, липса на организация на материални системи.

В съответствие с втория закон на термодинамиката затворена система, т.е. система лишени от възможността за обмен в реално енергийно информация с външната среда, да се потърси и с течение на времето ще дойде неизбежно естествено стабилно равновесие на вътрешното състояние, което съответства на държавата, с максимална ентропия. Затворена система клони към хомогенност на неговите елементи и равномерността на разпределението на енергия на връзките между тях. Т.е. при липса на информационния процес забравя натрупаните материя информация спонтанно.

Вече споменахме, че формулата Хартли - специален случай на формула на Шанън за еднакво вероятни алтернативи.

Заместването с формула (1), вместо да го пи (в случая на equiprobable независимо от I) стойност. получаваме:

. Така Hartley формула е много проста:

От това следва ясно, че по-голям броят на алтернативи (N), толкова по-голяма несигурност (Н). Тези количества са свързани по формула (2) не е линейно, но чрез двоичен логаритъм. Логаритъма при основа 2 и получената брой възможности за мерните единици информация - бита.

Имайте предвид, че ентропията ще бъде цяло число, ако N е с мощност от 2, т.е. ако N принадлежи към серията:

Фиг. 10. В зависимост от размера на ентропията equiprobable избор (еквивалентни алтернативи).

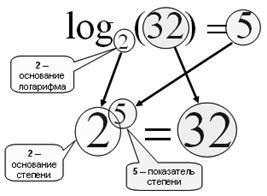

Спомнете си, че логаритъм.

Фиг. 11. Намирането на логаритъм от б до основата на - тази констатация степен. там, където искате да се изгради. за да получите б.

Логаритъма при основа 2 се нарича двоичен:

log2 (10) = 3.32 => 10 2 = 3.32

Логаритъм на база 10 десетични -nazyvaetsya на:

log10 (100) = 2> 10 2 = 100

Основните свойства на логаритъм:

1. дневник (1) = 0, тъй произволен брой нула степен дава 1;

За разтвори на обратни проблеми, когато известни несигурност (Н) или получени чрез отстраняването му количество информация (I) и е необходимо да се определи колко алтернативи също така съответства на появата на тази несигурност, като се използва обратен формула Hartley, което е още по-лесно:

Например, ако знаем, че в резултат на определянето, че ние се интересуваме Кол Иванов живее на втория етаж, е получен 3 бита информация, броя на етажите в сградата може да бъде определена по формула (3), N = 2 март = 8 етажа.

Ако въпросът е: "в сградата на 8 етажа, колко информация трябва да се научим, че ние се интересуваме от Коля Иванов живее на втория етаж", трябва да използвате формулата (2): = I log2 (8) = 3 бита.

Свързани статии