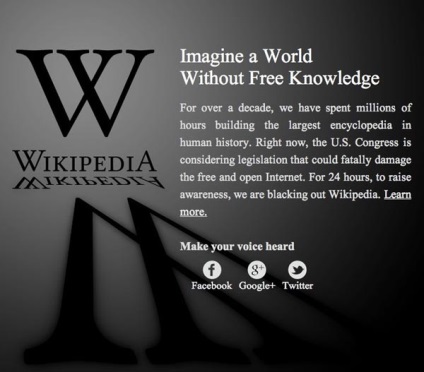

Много уебмастъри имам един въпрос: как да се направи «затъмнение», но това не вреди на сайта? уеб администраторите на форуми на Google се появиха JohnMu пост служител с подробни препоръки на сайта затвори. Тези насоки са полезни не само за да протестират законодателството на САЩ, но и за всички уебмастъри, които могат да бъдат необходими за временно затваряне на сайта, за да се актуализира, верни на критични грешки и т.н. Във всеки случай е по-добре да не изключите сайта е, но ако това е задължително, а след това трябва да се прави правилно. Това е, което препоръчва Google служител:

Използвайте 503 HTTP-статус, но внимателно прочетете Често задавани въпроси.

Най-често срещаният сценарий - на уебмастера да решат да заменят съдържанието на сайта си, като просто премахнете текста и да оставите някои "съобщение". Важно е в този случай да се направи замяна 503 HTTP-статус за всички на URL адреса, участващи в "действие" (конкретната страница или целия сайт).

а) това би означавало, че не е "истински" съдържание, както и че няма да бъдат индексирани; б) като се взема предвид първата точка, дори и ако ние виждаме едно и също съдържание (посланието на политически протест, например) на всички страници, проблемите и санкции, свързани с дублиране на съдържанието няма да бъде; в) скоростта на индексирането на сайта ще намалее, ако сайтът дава код 503. Това е неизбежно, но това няма да доведе до дългосрочни проблеми, както и скоростта на индексиране на вашия сайт, за да се възстанови бързо след сайт ще даде 200-кода. Колко бързо се връща към нормалното индексация това зависи от вашия сайт.

Две важни забележки за robots.txt

а) Google Bot вече е настроен така, че да спре индексирането на сайта, ако robots.txt дава 503 код на отговор. Индексирането се възстановява едва след като роботът ще получи 200 или 404 сървъра код на отговор, когато иска robots.txt. Затова, ако решите да блокирате само част от сайта, се уверете, че robots.txt не даде код 503. В противен случай, ще се заключи, след като в целия сайт от робота на Google.

б) Някои уебмастъри решат да променят robots.txt, за да спре индексирането на сайта и добавяне на директива "Disallow: /". Никога не блокирайте бота на Google по този начин - това може да доведе до проблем, чието решаване ще отнеме много повече време от няколко дни.

Забелязана грешка? Изберете го и натиснете Ctrl + Enter.

Свързани статии