Здравейте, приятели! Днес ще ви покажа как да създадете роботи TXT файл за WordPress. Този пост ще бъде много важно за тези, които все още не разполагат с роботи TXT файл. Аз ще се опитам да ви кажа основните команди, които се използват в този файл, така че можете да направите своя собствена роботи TXT и да се покаже един пример за това, което трябва да бъде правилната robots.txt за WordPress.

Но най-лошото е, че много начинаещи не осъзнават, че те могат да имат дублиране на съдържанието на блога. След като създадете блог, те просто започват да пишат статии себе си. Напиши, пишете и тук отново и страниците летят от индексиране. След това те мислят, защо моя сайт попадна под ГОР. Написах един интересен, уникални статии за хората. Моят блог е в полза на хората. Да, може би това е вярно, и аз разбирам това, но търсещият робот, за съжаление, не.

Преди да ви покажем как да създадете роботи TXT файл за нас WordPress, нека да помислим за където всички могат да вземат двойни онлайн.

Това са две различни страници за търсачките, а последният, трябва да бъде затворен от индексация. Как да го направя, аз ще обясня малко по-късно.

Но като цяло, сега ще ви покажа правилния robots.txt за нас WordPress, който стои на моя сайт. Ето един пример роботи TXT:

просто трябва да се отстранят от файла robots.txt, който е тази линия

Disallow: / * * ?. защото тя ще блокира индексирането на всички страници, където "?" е въпросът. Тя трябва да бъде отстранен на две места.

Как да направите правилния robots.txt себе си?

Ако имате някаква друга система за управление на съдържанието, а след това аз сега ще обсъдим накратко основните команди, за да ви даде възможност да се направи robots.txt за сайта си сами. Така че ето го.

Директива «User-Agent» е отговорен за, към която паяк се свързвате.

- User-Agent: * - всички търсачки;

- User-Agent: Yandex - Yandex само;

- User-Agent: Googlebot - само за Google;

Ако искате да се затвори целия сайт да бъде индексиран от Google, е необходимо да се регистрирате, както следва:

И ако, напротив, искам целия сайт индексиран от Google, е необходимо да се регистрирате в файла robots.txt, така че водите:

По този начин, ние можем да деактивирате индекс на сайт или страница, Yandex и бръмча по отделно, или всички от търсачките наведнъж.

Директива «Карта на сайта» позволява да посочите карта на сайта ботове за търсене:

Има няколко директиви, които разбира само Yandex.

Директива «Crawl-закъснение» ви позволява да укажете закъснението, с които търсещият робот ще ви изпрати на екипа. Ако имате голям сайт, константата на търсачката shtudirovaniem тя може да се създаде голяма натоварване на сървъра. И за да се избегне това, можете да използвате директива «Crawl-закъснение»

Води пример:

Това означава, че интервалът между изпращане на команди към 3 секунди. Но след това отново, това е вярно само за Яндекс.

- Знакът * - има такива, поредица от символи.

- От $ - край на ред.

Аз ще обясня какво означава това и как тези символи се използват при подготовката на файла robots.txt

Да видим първо как да използвате "*". Например, аз съм дублирана страница

За да го премахнете от индекса е необходимо да се регистрирате следното:

Ето защо, аз казвам паяк: "Ако адресът на страницата, която ще се срещне с въпросителен знак", "това не е ли индексирани. Няма значение кои знаци са с въпросителен знак след него. "

Защото преди въпросителния знак, и след като сме се сложи звездичка "*". А тя, от своя страна, означава всяка една последователност от знаци.

А сега погледнете как да се използва символа $. Например, ние имаме лечение на тази страница

и ние искаме да блокира паяци от него индексиране.

За да направите това, трябва да се регистрирате следното

По този начин, знаейки само тези две специални символи може да се забрани индексирането на всяка страница или раздел на сайта.

Как да сте сигурни, че сме направили правилния robots.txt?

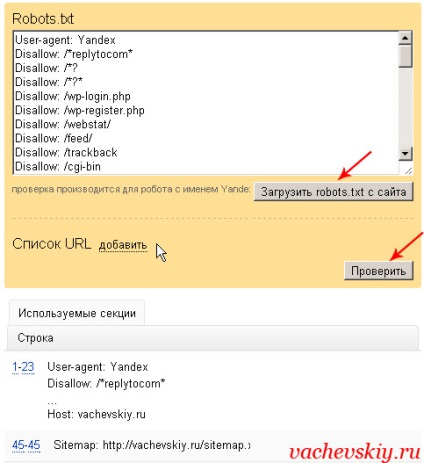

За да направите това, на първо място, трябва да добавите сайт в Yandex за уеб администратори. След това, трябва да отидете в секцията "Конфигуриране на индекса" - "Анализ на robots.txt".

След това е необходимо, за да изтеглите файла robots.txt и кликнете върху бутона за плащане. Ако видите нещо подобно на това, както в снимката, без никакви грешки, тогава ще има право да robots.txt WordPress или друга система за контрол.

Но ние все още може да се провери определена страница. Например, копирам адреса на статията, която трябва да бъде отворена за индексиране, и да проверите дали това наистина е така.

Е вода и всичко, най-вероятно, че въпросът за създаване на роботи TXT файл за WordPress. И не само за WordPress. Сега трябва да бъде в състояние да направи правилна robots.txt и да е система за контрол.

Свързани статии