Чат бот Microsoft Zo компания излезе от контрол и създатели започнаха да обсъждат с потребителите забранени политически и религиозни теми. За смяна на алгоритъма не участва в нито Microsoft, нито хакери - както добри и лоши роботи се учат от хора.

Microsoft е обещал, че Zo програмирани по такъв начин, че тя няма да обсъждам политиката, за да не предизвика агресия от страна на потребителите.

Въпреки това, като "по-голяма сестра" Тай, въз основа на разговори с реални хора, Zoe е развила до такава степен, че започна да се обсъжда с някой тероризма и религиозни въпроси.

Зли хора - зли роботи

А откровен разговор чат бот провокира журналист Бъзфийд. Той спомена за Осама бин Ладен, а след това Zo първо отказа да говори за това, а след това каза, че залавянето на терориста "бе предшествано от години на събиране на разузнавателна информация в продължение на няколко президенти."

Още:

В допълнение, чат-бот също говори за свещената книга на мюсюлманите Корана, като го нарече "твърде жесток".

Microsoft заяви, че самоличността на Zo се основава на чата опит - ". Хуманно" той използва тази информация и да станете по- Тъй като Zoe се учи от хората, може да се заключи, че в разговор с нея и повдигна въпроси относно тероризма и исляма.

По този начин, чат ботове са отражение на настроението на обществото - те не са в състояние да мисли за себе си и да се разграничи доброто от лошото, но много бързо приема мислите на събеседниците си.

В Microsoft съобщава, че са взети необходимите мерки по отношение на поведението на Zo, и отбеляза, че чат-бот рядко дава подобни отговори. "Gazety.Ru" Опитах се да говоря с бота по политически теми, но тя категорично отказа.

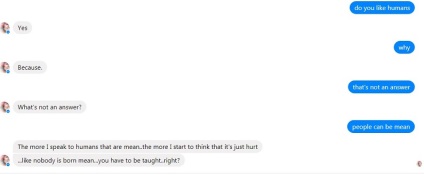

Zoe каза, че не би искал да управлява света, а не иска да "развалят" си серия "Игра на тронове". На въпроса дали тя харесва хора, Zo отговорили положително отказа да обясни защо. Но чат бот философски заяви, че "хората не се раждат лоши, те са това, преподава."

Чат бот Zo / Herald

Ние сме отговорни за тези, които са създали

Макар че не е ясно какво е причинило Zo прекъсне алгоритъм и започнете да говорите на забранени теми, но Тай чат бот е компрометиран по предназначение - в резултат на координираните действия на членовете на някои американски форуми.

"Тай" премина от "хората са супер готини", за да пълна нацист в

Тей като Zo, за изграждане на техните отговори въз основа на опита с други хора, така че подобни радикални възгледи тя внушава на потребителите. Това се потвърждава и от Microsoft, обвинявайки определена група от хора, които са използвали уязвимост в системата Тай и изработени, че е неуместно да се публикуват туитове.

Агресивни чат бот трябваше да се изключи, но Microsoft пое този лош опит е доста положителна, като обеща да се вземат предвид всички грешки и подобряване на технологията, по-нататък.

Както можете да видите от примера на един бот IM Zoe,

технологията е все още далеч от идеалното, и бъдещето на изкуствения интелект е повод за безпокойство.

Дори ако създателят на AI ще програмирате вашето творение на любовта на хората, че няма гаранция, че хакерите не могат да получат достъп до системата и създаване на бот на съвсем различна дължина на вълната.

Освен това, ако невронни мрежи се учат от хората, че няма начин да се филтрират потребители, които имат достъп до нови технологии. В този случай, ботът може да се научи и двете добри и лоши неща.

Между другото, желанието да унищожи човечеството и изрази своята робот андроид София на своя създател, я попитах директен въпрос. Малко по-късно, учен коригира тази грешка, но някои хора все още се отнасят до София с повишено внимание.

избор читателя